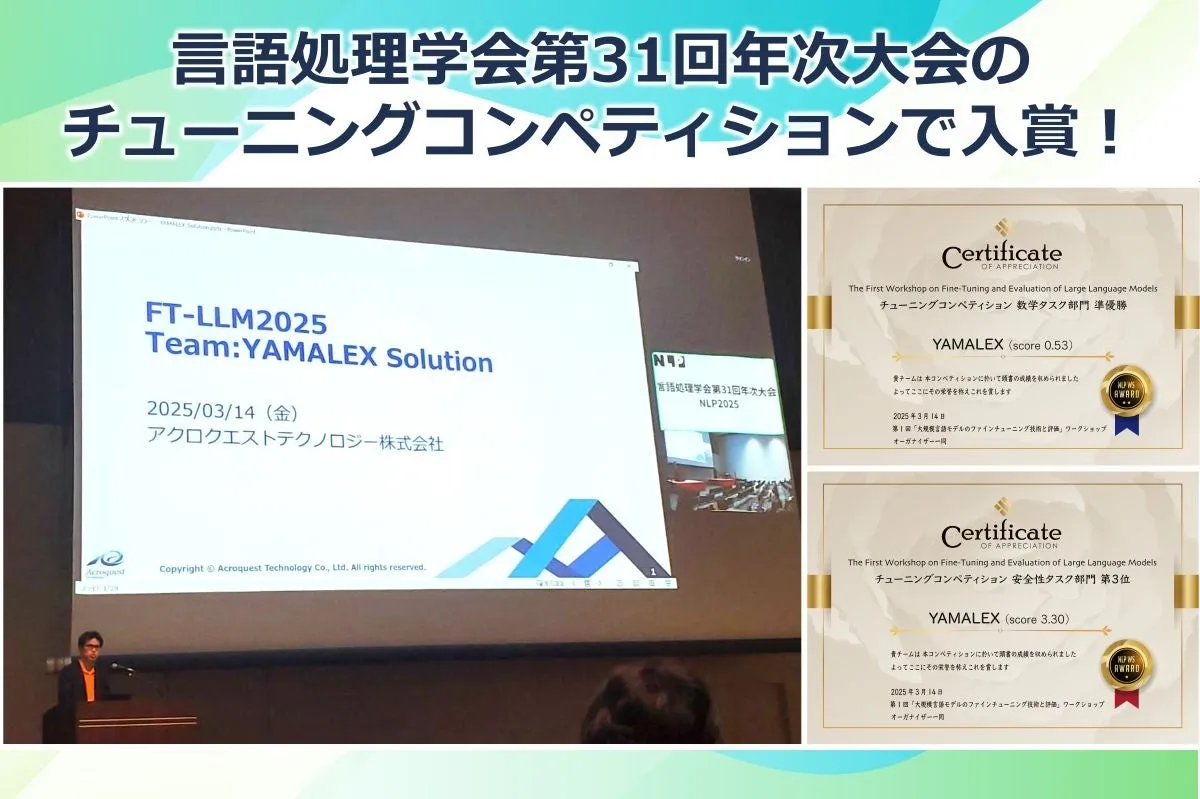

アクロクエストのYAMALEXチーム、言語処理学会での大会で二冠達成!

アクロクエストのYAMALEXチーム、言語処理学会での大会で入賞!

アクロクエストテクノロジー株式会社のデータサイエンスチーム「YAMALEX」が、言語処理学会第31回年次大会(NLP2025)において開催された「チューニングコンペティション」で素晴らしい成果を収めました。この大会で、YAMALEXは2つの部門において入賞を果たしました。その成果について詳しくお伝えします。

大会概要

今年2025年3月に行われた「第1回大規模言語モデルのファインチューニング技術と評価」ワークショップでは、言語モデルのファインチューニング技術に焦点を当て、多くの研究者が参加して技術の向上を図る機会が提供されました。このワークショップ中に行われたコンペティションでは、チーム間での様々なファインチューニング技術が競われ、その成果が評価されました。

このコンペティションは、以下の2つのタスクに基づいて行われました。

1. 安全性チューニングタスク: 質問応答(QA)データセットを用い、安全性の維持と有用な応答を作り出す能力に関するものでした。

2. 数学チューニングタスク: 数学や算数の問題解決能力をクローズアップし、チューニングを通じてその能力を向上させることを目的としていました。

YAMALEXチームの成果

参加した全18チームの中で、YAMALEXは両タスクにおいて顕著な結果を残しました。安全性タスクでは第3位、数学タスクでは準優勝という素晴らしい成績を収めました。この成果は、LLM(大規模言語モデル)を用いた技術の向上に向けた新たな可能性を示しています。

YAMALEXチームは、ファインチューニングを通じて得られた知見を活かし、データセットの構築やコード生成、思考能力の向上に努めた結果、精度向上を実現しました。

チームメンバーのコメント

YAMALEXチームのリーダーでKaggle Grandmasterの山本大輝氏は、コンペティションへの参加を通じて、LLMへのコードや数学的思考の与え方について多くを学んだと述べています。特に、標準モデルでは低い精度をどのように改善するかを考え、これを実現できたことが2位入賞につながったと語ります。

機械学習エンジニアの佐々木峻氏は、ファインチューニングのプロセスにおいて様々な学びがあり、特に時間の使い方についての工夫が重要であったとコメントしています。

今後の展望

アクロクエストは、今後もAIや機械学習、データ解析技術のさらなる向上を追求し、顧客の課題解決に貢献できるよう努力してまいります。今回の大会で得た経験を活かし、さらなる技術革新を目指して邁進していく所存です。

詳しい情報については、言語処理学会公式サイトやYAMALEXチームによる発表資料をご覧ください。

トピックス(その他)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。